前置: Ch5.Convex

Non-differentiable Problems

(Projected) Sub-gradient Method

Definition

当且仅当满足

的时候, 称之为sub-gradient

其中是的任意的sub-gradient

Theorem

chain rule:

composition: , 假设, 且, 那么有:

pointwise maximum: 如果有, 那么有: , 指的是convex hull of subdifferentials of all active functions

pointwise supremum: 对于, 有: , closure的定义参见闭包仿射部分

Example

假设有norm: , 对于满足, 有

其中, 是原始norm的对偶:

Example

l1-norm:

因为

因此有

Fundamental inequality for projected sub-gradient methods

majorization-minimization

找到另一个函数majorizes , 然后优化这个函数

Lemma

Projected sub-gradient 更新规则 满足:

Polyak’s step size rule

推荐的step size: , 其error reduction为:

当已知的时候很有用

Convergence Rate是sublinear,

Theorem

假设是convex且-Lipschitz continuous的. 那么projected sub-gradient method 应用Polyak’s step size有:

Theorem

假设是convex且-Lipschitz continuous的. 那么projected sub-gradient method, 但是没有应用Polyak’s step size, 有:

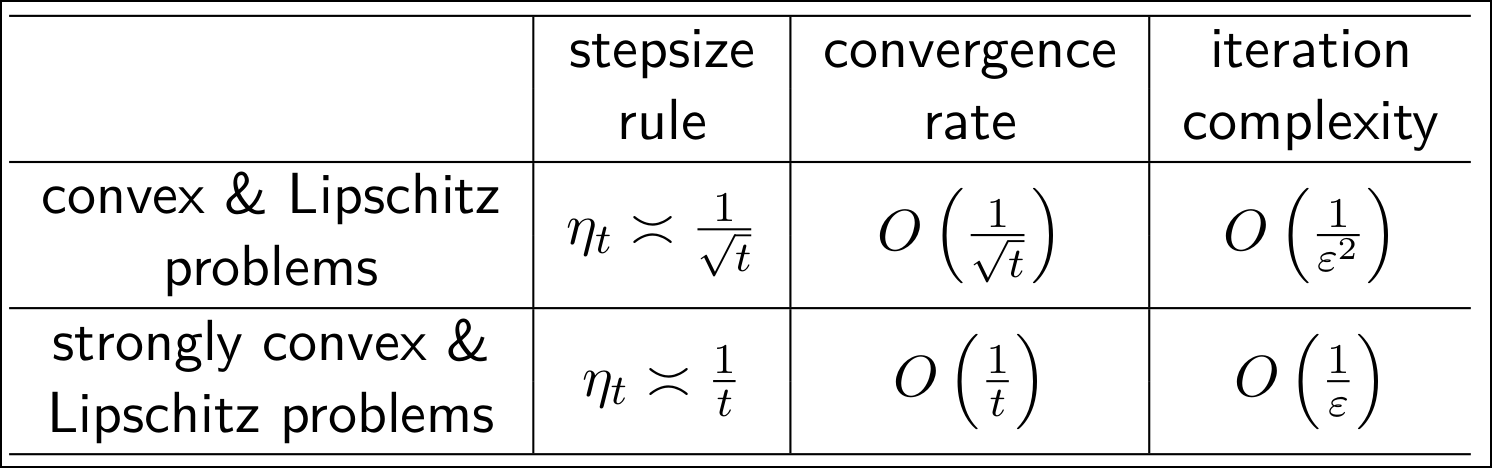

summary: